Dödande maskiner väcker debatt om krigets lagar

Analys. Drönare har satts in i strid i flera årtionden och har på senare tid fått stor uppmärksamhet i kriget i Ukraina. De används av båda sidor för att genomföra anfall samt filma egna framgångar och motståndarens förluster. Obemannade vapen väcker frågor om huruvida livsavgörande beslut överlåts åt maskiner, och om den befintliga folkrätten behöver kompletteras med nya regler för krigföring, skriver forskningsledaren Martin Hagström och analytikern Jessica Appelgren, båda vid Totalförsvarets forskningsinstitut (FOI).

Publicerad: 2022-07-07

Under en fisketur anfalls USA:s president plötsligt av en mängd drönare. Drönarsvärmar överraskar också på universitet, dödar studenter och medlemmar ur politiska proteströrelser.

Känns temat igen? I litteraturen har artificiell intelligens, AI, som löper amok och dödliga robotar funnits länge. Filmer med AI som i slutet besegras av hjälten är också många. Det kanske mest kända exemplet är Skynet från Terminator-filmerna. Militären utvecklar AI-systemet Skynet som blir självmedvetet och försöker förgöra mänskligheten med kärnvapen. I filmen Slaughterbots utvecklar ett företag drönare som ett militärt vapen. Men drönarna används i stället för att via sociala medier spåra och döda både politiska motståndare och ungdomar som deltar i protester. Det finns både föregångare och efterföljare på samma tema. Föreställningen om konstgjorda krigare har funnits ända sedan antiken och i takt med teknikutvecklingen har de ändrat skepnad.

Obemannade flygande farkoster, ofta kallade drönare, har funnits i över ett århundrade. De har använts militärt i över ett halvt århundrade, men fått allt större uppmärksamhet de senaste åren. Drönares roll i krigföring har också gradvis ökat. Vad som en gång var en exklusiv resurs för högteknologiska stater med USA och Israel i spetsen, är i dag en lättillgänglig och överkomlig teknik för många stater. Den civila teknikutvecklingen har också gjort det möjligt för allmänheten att köpa små farkoster som enkelt kan flygas tack vare avancerade algoritmer som styr själva farkosten medan piloten manövrerar den från en telefon eller läsplatta.

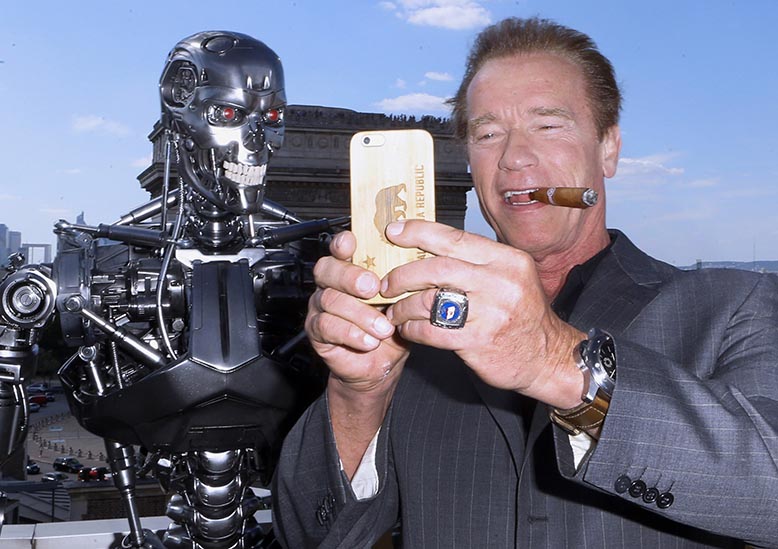

Verkligheten kommer i kapp filmen, med dess beväpnade robotar och AI-system med kärnvapen? Arnold Schwarzenegger vid lanseringen 2015 av "Terminator: Genisys". Foto: Jacques Brinon/AP/TT

Verkligheten kommer i kapp filmen, med dess beväpnade robotar och AI-system med kärnvapen? Arnold Schwarzenegger vid lanseringen 2015 av "Terminator: Genisys". Foto: Jacques Brinon/AP/TT

Från stora flyg till hobbydrönare

Beväpnade drönare har använts i stor omfattning i de senaste konflikterna i Syrien, Irak, Libyen och Nagorno-Karabach. USA hade tidigt en drönarflotta med stora flygplan, men eftersom utvecklingen nu har gjort tekniken tillgänglig för många aktörer finns det också många exempel på enkla konstruktioner med små hobbydrönare som bär granater. Kriget i Nagorno-Karabach år 2020 kallas ibland för ”drönarkriget” då Azerbajdzjan med stöd av Turkiet använde beväpnade obemannade flygfarkoster för att slå ut fordon och soldater på den armeniska sidan. I TV och på sociala medier spreds filmer från drönare som skulle visa att de som hade den moderna tekniken var överlägsna dem som saknade den.

På samma sätt används drönare i kriget i Ukraina för att genomföra och filma anfall samt dokumentera de egna styrkornas framgångar – filmer som sedan sprids på sociala medier. Beväpnade drönare eller vapen som flyger och själva beslutar om liv och död verkar vara en teknisk möjlighet, och i nyhetsrapportering från kriget i Ukraina kommer uppgifter om drönarnas framgångar på slagfältet. Har verkligheten kommit i kapp filmens värld?

Även små drönare kan användas i krig. 15-årige Andrij Pokrasa och hans far hyllas i Ukraina för att ha lokaliserat ryska mål som den egna regeringsarmén har kunnat slå ut. Foto: Natacha Pisarenko/AP/TT

Även små drönare kan användas i krig. 15-årige Andrij Pokrasa och hans far hyllas i Ukraina för att ha lokaliserat ryska mål som den egna regeringsarmén har kunnat slå ut. Foto: Natacha Pisarenko/AP/TT

AI är också ett område där stora framsteg har gjorts de senaste tio åren. Användningen av AI kan ses som ett hot, men också som en möjlighet. I våra telefoner finns smarta hjälpmedel som till exempel hjälper oss att söka i bildbibliotek eller hitta till närmaste kafé, funktioner som var närmast science fiction för bara 20 år sedan.

AI är inte en teknik utan ett samlingsnamn för olika sätt att skapa datorprogram som kan automatisera problemlösning. AI-forskningen har en lång historia och begreppet myntades på 1950-talet när datorer kunde programmeras att lösa logiska problem. De senaste framstegen inom språkmodellering är hisnande, med datorer som kan föra en konversation som i många avseenden känns mänsklig eller automatisk ansiktsigenkänning som används i passkontroller världen över.

"Killer robots"

Att beskriva komplicerad teknik i termer av mänskliga egenskaper, så kallad antropomorfisering, är praktiskt. Det finns många exempel på detta inom AI-området, exempelvis ”lärande system” och ”maskiner som fattar beslut”. Även om sådana formuleringar förenklar skapar de lätt förvirring och otydlighet kring systemens faktiska egenskaper. Trots de fantastiska egenskaperna handlar det i grund och botten fortfarande bara om avancerade räknemaskiner som ska betraktas som just sådana.

Utvecklingen inom AI och drönare har öppnat för en ny debatt. Den började när USA startade ett nytt arbete med att utveckla och införa fler ”autonoma” system i försvaret. Detta startade en rörelse som ifrågasätter automation och AI i militära tillämpningar. Debatten förs i civilsamhället och även i FN:s forum för begränsning och användning av konventionella vapen. Där deltar både stater och organisationer. Begreppet Lethal Autonomous Weapon Systems, LAWS, kom tidigt att användas om de framtida vapensystem som sågs som ett hot. Dessa kallas också för killer robots av dem som vill förbjuda dem.

Serbisktillverkad, kulsprutebestyckad markdrönare visas upp på en mässa i Abu Dhabi. Foto: Jon Gambrell/AP/TT

Serbisktillverkad, kulsprutebestyckad markdrönare visas upp på en mässa i Abu Dhabi. Foto: Jon Gambrell/AP/TT

LAWS är inte nödvändigtvis dödligare än dagens vapensystem, men det finns en oro för att tröskeln för staters våldsanvändning skulle kunna sänkas med sådana vapen. Det finns också en rädsla för att väpnade konflikter på grund av automatiska funktioner skulle kunna startaoavsiktligt och att teknikutvecklingen ska medföra en destabiliserande kapprustning. En annan fråga handlar om etik och mänsklig värdighet. Maskiner som fattar beslut om liv och död är för många oacceptabla, medan andra inte ser någon skillnad mellan att bli dödad av slumpmässigt splitter eller av ett automatiskt vapen.

Debatten kring LAWS har kommit att handla mycket om huruvida de bör förbjudas. För att införa ett folkrättsligt förbud mot autonoma vapensystem behöver man beskriva vad ett sådant system är. Finns det till exempel något som skiljer ett autonomt system från ett automatiskt? För tekniska system är skillnaden mellan ett autonomt och ett automatiskt system en fråga om ordval men inte någon verklig skillnad i teknik. ”Autonomt” används för komplex automation medan automatisk används för välkända automatiska funktioner. Att ur ett tekniskt perspektiv beskriva vissa ”autonoma” egenskaper som otillåtna är därför svårt och kan inte utgöra en fungerande grund för reglering.

Människan alltid ansvarig

Folkrätten, och specifikt krigets lagar, reglerar vad som är tillåtet i väpnade konflikter. Ny teknik som vapensystem med autonoma funktioner får bara användas i enlighet med folkrätten. Men en fråga är om existerande folkrätt är tillräcklig eller om den behöver kompletteras. Ansvaret för all vapenanvändning ligger hos människan och måste uppfylla de grundläggande principerna om distinktion, proportionalitet och försiktighet. Det måste alltså fortfarande gå att skilja militära mål från civila, väga oavsiktliga förluster mot militär nytta och vidta alla praktiskt möjliga åtgärder för att undvika eller åtminstone minska civila förluster.

Jemen har varit mål för många amerikanska drönarattacker. I denna ska nio misstänkta al-Qaida-medlemmar ha dödats, men också flera civila. Foto: Nasir al-Sanna'a/AP/TT

Jemen har varit mål för många amerikanska drönarattacker. I denna ska nio misstänkta al-Qaida-medlemmar ha dödats, men också flera civila. Foto: Nasir al-Sanna'a/AP/TT

Att göra detta kräver kvalitativ bedömning som bygger på mänskligt omdöme, något som många anser inte kan överlåtas åt datorer. Alla stater är också skyldiga att granska om användningen av ett nytt vapen kan vara förbjuden enligt landets folkrättsliga skyldigheter. Vapensystem med många autonoma funktioner är komplexa och kan därför göra den folkrättsliga granskningen svår. Mer utvecklade metoder för granskning kommer förmodligen att behövas.

Debatten kring automation i våldsanvändning är mångsidig och komplex, det finns åtskilliga argument både för och emot. Det är av stor vikt att förstå vilka begränsningar som rättsliga ramverk utgör för användningen av vapensystem med autonoma funktioner. Det är svårt att ur ett tekniskt perspektiv definiera vad som är eller bör vara förbjudet, vilket gör det viktigt att förstå hur den mänskliga kontrollen ska säkerställas och beskrivas för olika typer av högautomatiserade system. Kraven på systemen, organisation och metoder för användning kommer att vara högre än för dagens vapen.